解决deepseek服务器响应延迟

随着计算机快速发展,踊跃出一批批优秀的AI工具,例如ChatGpt、文心一言、kimi、豆包等

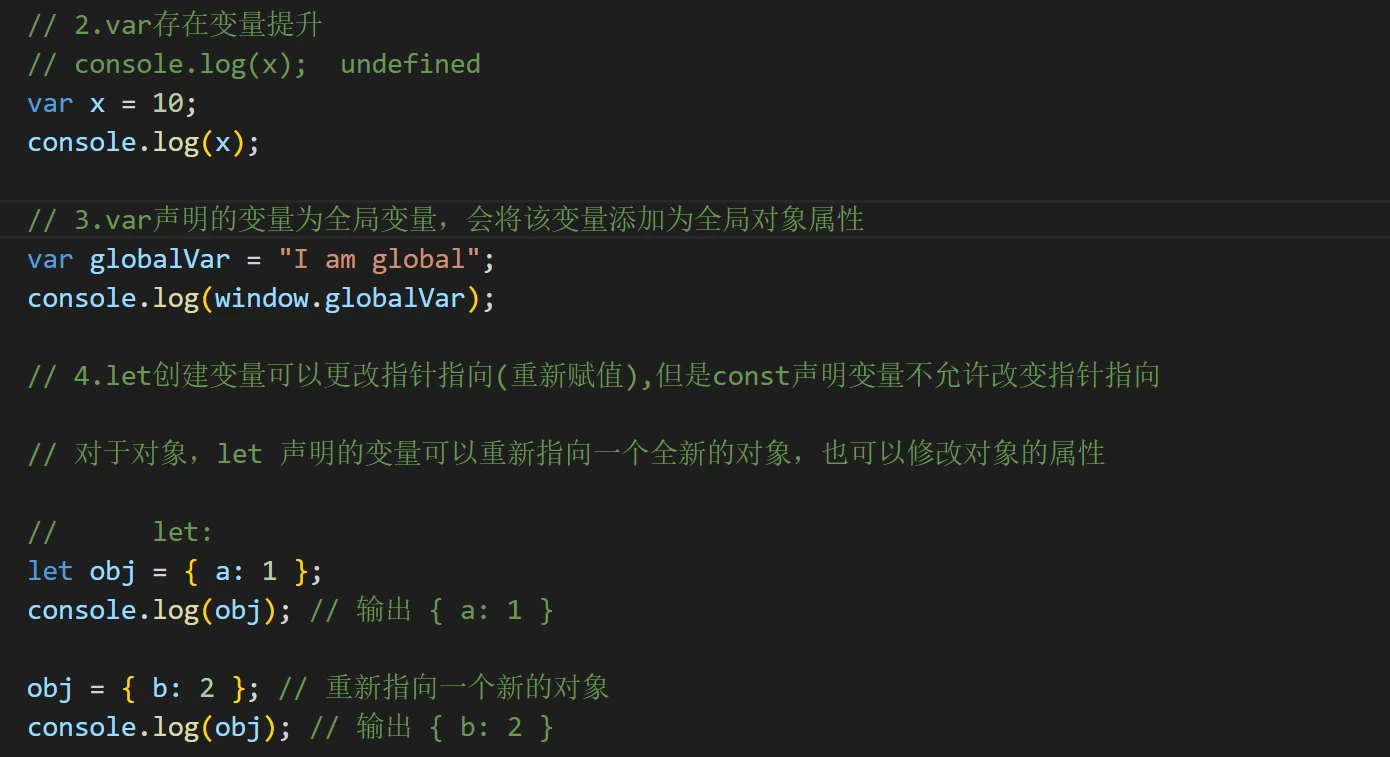

deepseek作为一款开源且性能强大的语言模型,提供了灵活的本地部署方案,让用户能够在本地环境中高效的运行模型,同时更能保护好用户的隐私

deepseek作为一款开源且性能强大的语言模型,提供了灵活的本地部署方案,让用户能够在本地环境中高效的运行模型,同时更能保护好用户的隐私

部署方式一

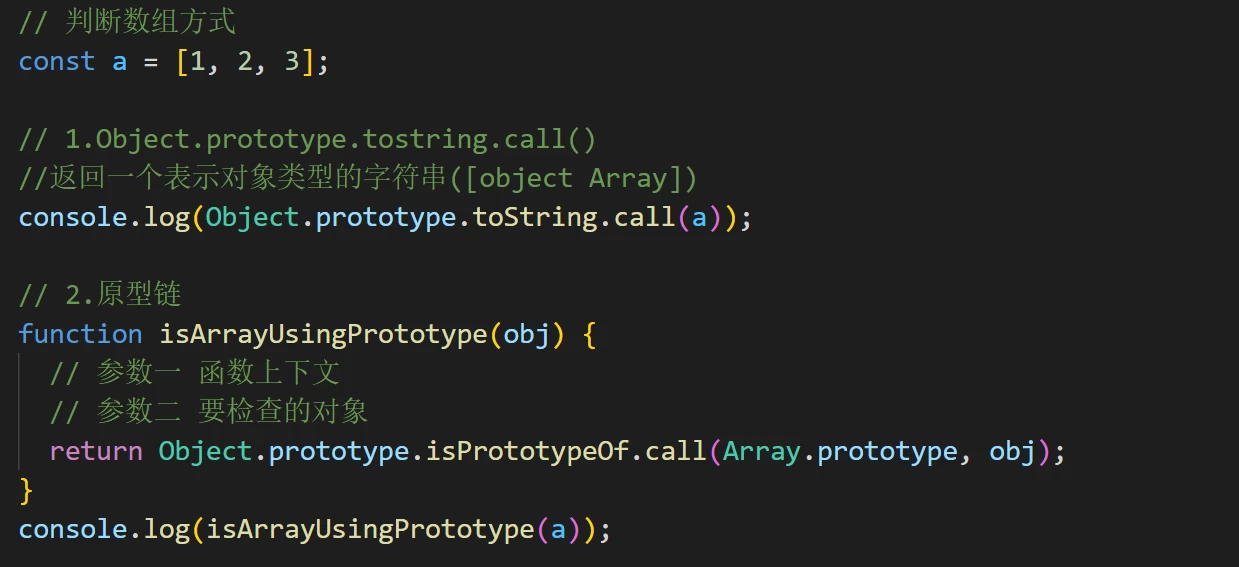

API+DeepSeek服务器

github上下载Cherry Studio,调用本地deepseek生成的密钥,贴上对应模型即可

部署方式二

访问第三方平台

秘塔AI

部署方式三

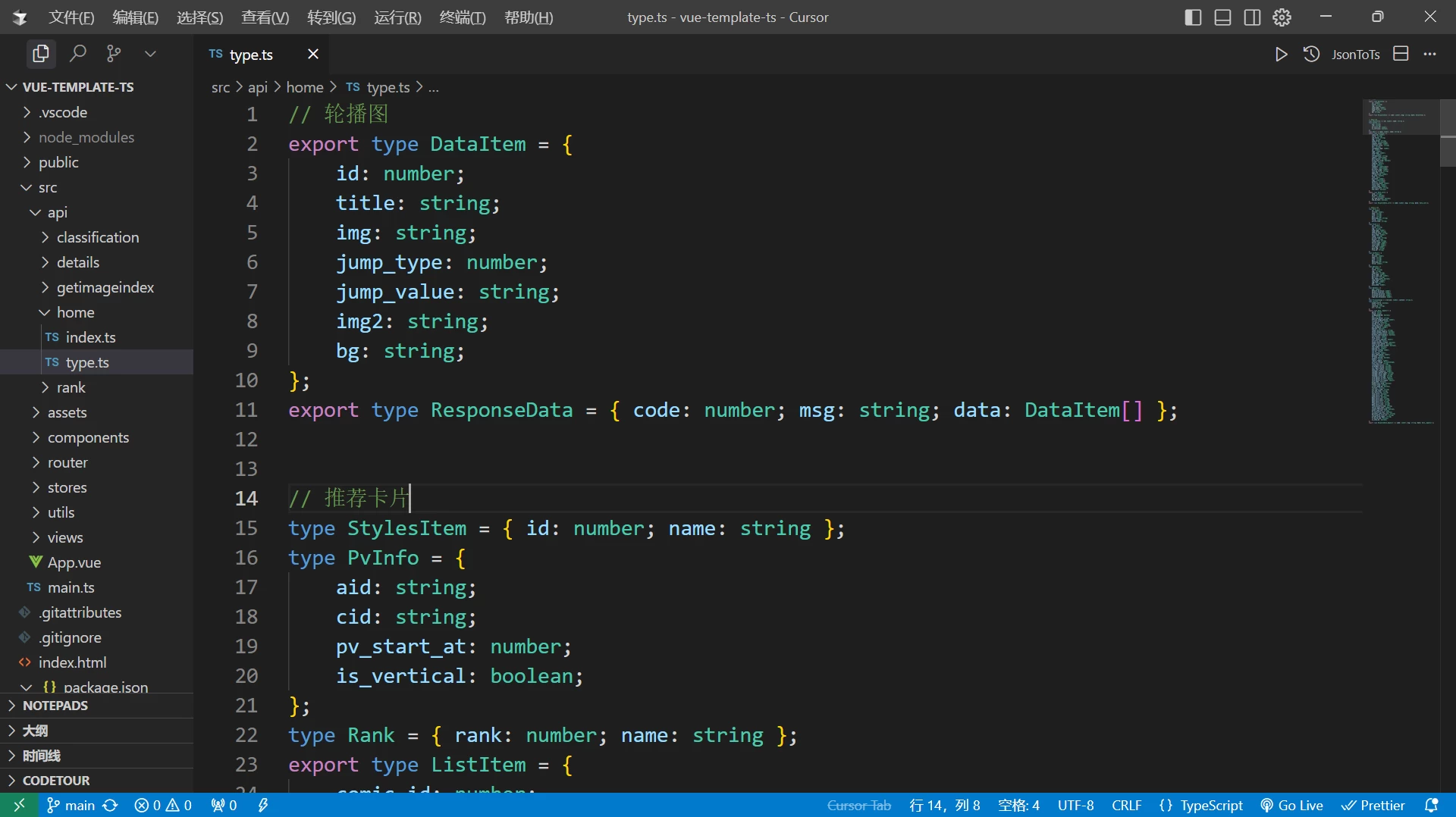

LM Studio本地部署

找到对应的版本,直接下载就可以了,选择自己喜欢的模型

感谢尚硅谷过年期间对deepseek深入挖掘

注:图片来源于尚硅谷

阅读剩余

版权声明:

作者:Shican_FelixLiu

链接:https://www.shicanyyds.cn/index.php/2025/02/02/jiejuedeepseekfuwuqixiangyingyanchi/

文章版权归作者所有,未经允许请勿转载。

THE END